تهدیدات امنیتی ناشی از هوش مصنوعی در وب: بررسی چالشهای جدید

حملات فیشینگ و مهندسی اجتماعی پیشرفته

یکی از بارزترین تهدیدات هوش مصنوعی در وب، افزایش پیچیدگی و اثربخشی حملات فیشینگ و مهندسی اجتماعی است. الگوریتمهای هوش مصنوعی قادرند حجم عظیمی از دادههای کاربران را از شبکههای اجتماعی، وبسایتها و سایر منابع آنلاین جمعآوری و تحلیل کنند. با استفاده از این اطلاعات، مهاجمان میتوانند ایمیلها، پیامها و حتی وبسایتهای جعلی بسیار قانعکنندهتر و شخصیسازیشدهتری ایجاد کنند که تشخیص آنها از نمونههای واقعی برای کاربران عادی و حتی کارشناسان امنیتی دشوارتر است.

- تولید محتوای متقاعدکننده: ابزارهای تولید زبان طبیعی مبتنی بر هوش مصنوعی (مانند GPT-3 و مدلهای مشابه) میتوانند متونی تولید کنند که از نظر گرامری، سبکی و محتوایی بسیار شبیه به نوشتههای انسانی هستند. این امر به مهاجمان اجازه میدهد تا پیامهای فیشینگ را بدون اشتباهات نگارشی رایج در حملات سنتی ایجاد کنند.

- شخصیسازی در مقیاس وسیع: هوش مصنوعی میتواند به طور خودکار اطلاعات شخصی قربانیان مانند نام، شغل، علایق و ارتباطات اخیر را شناسایی و در پیامهای فیشینگ بگنجاند و در نتیجه احتمال موفقیت حمله را به شدت افزایش دهد.

- جعل عمیق (Deepfake): فناوری جعل عمیق، که از هوش مصنوعی برای تولید ویدیوها و صداهای جعلی اما بسیار واقعی استفاده میکند، میتواند برای جعل هویت افراد مورد اعتماد (مانند مدیران شرکت یا شخصیتهای عمومی) و فریب قربانیان به منظور افشای اطلاعات حساس یا انتقال وجه مورد استفاده قرار گیرد.

اکتشاف و بهرهبرداری خودکار از آسیبپذیریها

هوش مصنوعی میتواند فرآیند کشف و بهرهبرداری از آسیبپذیریهای امنیتی در وبسایتها و برنامههای کاربردی وب را تسریع و خودکار کند.

- فازینگ هوشمند (Smart Fuzzing): فازینگ یک تکنیک تست نرمافزار است که در آن دادههای نامعتبر، غیرمنتظره یا تصادفی به عنوان ورودی به یک برنامه داده میشود تا خطاهای احتمالی و آسیبپذیریهای امنیتی شناسایی شوند. هوش مصنوعی میتواند با یادگیری از الگوهای آسیبپذیریهای قبلی، ورودیهای هوشمندانهتری برای فازینگ تولید کند و به طور موثرتری نقاط ضعف را کشف نماید.

- تحلیل کد مبتنی بر هوش مصنوعی: الگوریتمهای یادگیری ماشین میتوانند کد منبع برنامههای وب را برای شناسایی الگوهای کدنویسی ناامن و آسیبپذیریهای بالقوه تحلیل کنند. این قابلیت به مهاجمان اجازه میدهد تا به سرعت آسیبپذیریها را حتی در سیستمهای بزرگ و پیچیده پیدا کنند.

- توسعه اکسپلویتهای خودکار: پس از شناسایی یک آسیبپذیری، هوش مصنوعی میتواند به مهاجمان در توسعه خودکار کدهای مخرب (اکسپلویت) برای بهرهبرداری از آن آسیبپذیری کمک کند و سرعت پاسخگویی تیمهای امنیتی را به چالش بکشد.

باتنتهای هوشمند و حملات DDoS تکاملیافته

باتنتها شبکهای از دستگاههای آلوده هستند که توسط یک مهاجم کنترل میشوند و برای انجام حملات مختلف مانند حملات منع سرویس توزیعشده (DDoS) مورد استفاده قرار میگیرند. هوش مصنوعی به مهاجمان امکان میدهد باتنتهای هوشمندتر، مقاومتر و مخربتری ایجاد کنند.

- رفتار تطبیقی و گریز از تشخیص: باتنتهای مبتنی بر هوش مصنوعی میتوانند الگوهای ترافیک شبکه را تحلیل کرده و رفتار خود را برای گریز از سیستمهای تشخیص نفوذ و ابزارهای امنیتی تطبیق دهند. آنها میتوانند حملات خود را به گونهای زمانبندی و توزیع کنند که شناسایی منبع اصلی حمله دشوارتر شود.

- حملات DDoS چندوجهی و هوشمند: هوش مصنوعی میتواند حملات DDoS را با هدف قرار دادن هوشمندانه منابع حیاتی یک وبسایت و تغییر تاکتیکهای حمله به صورت پویا، مخربتر کند. این حملات میتوانند الگوهای استفاده کاربران عادی را تقلید کرده و تشخیص ترافیک مخرب از ترافیک قانونی را پیچیدهتر نمایند.

- استفاده از دستگاههای اینترنت اشیاء (IoT): با گسترش روزافزون دستگاههای IoT که اغلب از امنیت پایینی برخوردارند، مهاجمان میتوانند از هوش مصنوعی برای شناسایی و آلوده کردن این دستگاهها در مقیاس بزرگ و ایجاد باتنتهای عظیم استفاده کنند.

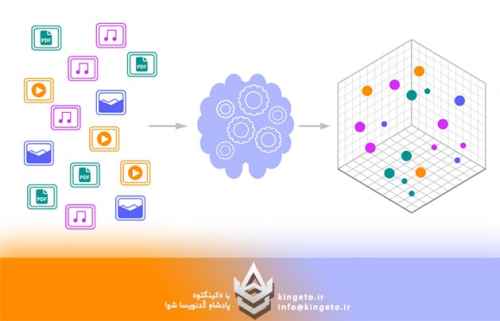

مسمومسازی دادهها و حملات به مدلهای یادگیری ماشین

بسیاری از سیستمهای امنیتی مدرن وب، از جمله سیستمهای تشخیص هرزنامه، بدافزار و نفوذ، خود از مدلهای یادگیری ماشین استفاده میکنند. مهاجمان میتوانند با هدف قرار دادن این مدلها، کارایی آنها را کاهش داده و سیستمهای دفاعی را تضعیف کنند.

- مسمومسازی دادهها (Data Poisoning): در این نوع حمله، مهاجم دادههای مخرب یا دستکاریشده را به مجموعه دادههای آموزشی مدل یادگیری ماشین تزریق میکند. این امر باعث میشود مدل الگوهای نادرستی را یاد بگیرد و در نتیجه در تشخیص تهدیدات واقعی دچار خطا شود یا حتی حملات خاصی را مجاز تلقی کند. به عنوان مثال، یک مهاجم میتواند با مسموم کردن دادههای آموزشی یک فیلتر هرزنامه، کاری کند که ایمیلهای فیشینگ او به عنوان ایمیلهای قانونی شناسایی شوند.

- حملات گریز (Evasion Attacks): در این حملات، مهاجم ورودیهای مخرب را به گونهای طراحی میکند که توسط مدل یادگیری ماشین به اشتباه به عنوان ورودیهای قانونی طبقهبندی شوند. به عنوان مثال، یک بدافزار نویس میتواند با تغییرات جزئی و نامحسوس در کد بدافزار خود، آن را از دید یک سیستم تشخیص بدافزار مبتنی بر هوش مصنوعی پنهان کند.

- حملات استخراج مدل (Model Extraction): مهاجمان ممکن است تلاش کنند تا با ارسال درخواستهای متعدد به یک سیستم مبتنی بر هوش مصنوعی و تحلیل پاسخهای آن، عملکرد داخلی و پارامترهای مدل را استخراج کنند. این اطلاعات میتواند برای طراحی حملات موثرتر یا حتی سرقت مالکیت معنوی مدل مورد استفاده قرار گیرد.

چالشهای دفاعی و راهکارهای مقابله

مقابله با تهدیدات امنیتی ناشی از هوش مصنوعی در وب نیازمند رویکردی چندلایه و پویا است. سازمانها و متخصصان امنیتی باید برای رویارویی با این چالشهای جدید آماده شوند.

- توسعه سیستمهای تشخیص تهدید مبتنی بر هوش مصنوعی: همانطور که مهاجمان از هوش مصنوعی استفاده میکنند، مدافعان نیز باید از این فناوری برای شناسایی و مقابله با حملات پیچیده بهره ببرند. سیستمهای تشخیص نفوذ و بدافزار مبتنی بر هوش مصنوعی میتوانند الگوهای رفتاری غیرعادی و تهدیدات نوظهور را با دقت بیشتری شناسایی کنند.

- امنیت مدلهای یادگیری ماشین: حفاظت از یکپارچگی و محرمانگی مدلهای یادگیری ماشین مورد استفاده در سیستمهای امنیتی حیاتی است. این امر شامل استفاده از تکنیکهای یادگیری ماشین مقاوم (Robust Machine Learning)، تشخیص حملات مسمومسازی داده و حملات گریز، و همچنین محدود کردن دسترسی به مدلها میشود.

- آموزش و آگاهیرسانی مستمر: کاربران همچنان یکی از ضعیفترین حلقههای زنجیره امنیت هستند. آموزش مستمر کاربران در مورد روشهای جدید فیشینگ و مهندسی اجتماعی مبتنی بر هوش مصنوعی، و همچنین نحوه شناسایی محتوای جعلی (مانند دیپفیکها) از اهمیت بالایی برخوردار است.

- بهروزرسانی و مدیریت آسیبپذیریها: با توجه به قابلیت هوش مصنوعی در کشف سریع آسیبپذیریها، سازمانها باید فرآیندهای مدیریت آسیبپذیری و اعمال وصلههای امنیتی خود را تسریع و تقویت کنند.

- همکاری و اشتراکگذاری اطلاعات: مقابله با تهدیدات هوش مصنوعی نیازمند همکاری بین سازمانها، محققان امنیتی و دولتها برای اشتراکگذاری اطلاعات در مورد تهدیدات جدید، تکنیکهای حمله و راهکارهای دفاعی است.

- قانونگذاری و چارچوبهای اخلاقی: توسعه و استفاده از هوش مصنوعی باید با چارچوبهای قانونی و اخلاقی همراه باشد تا از سوءاستفاده از این فناوری برای اهداف مخرب جلوگیری شود.

نتیجهگیری

هوش مصنوعی شمشیر دولبهای است که هم فرصتهای بینظیری برای پیشرفت وب به ارمغان میآورد و هم چالشهای امنیتی جدید و پیچیدهای را ایجاد میکند. حملات فیشینگ هوشمندتر، کشف خودکار آسیبپذیریها، باتنتهای تکاملیافته و حملات به خود مدلهای یادگیری ماشین، تنها بخشی از تهدیداتی هستند که امنیت وب را در عصر هوش مصنوعی به مخاطره میاندازند. برای مقابله موثر با این تهدیدات، نیازمند سرمایهگذاری در تحقیق و توسعه راهحلهای امنیتی مبتنی بر هوش مصنوعی، افزایش آگاهی و آموزش کاربران، و همکاری گسترده در سطح ملی و بینالمللی هستیم. آینده امنیت وب به توانایی ما در پیشبینی، شناسایی و پاسخگویی به این تهدیدات نوظهور بستگی خواهد داشت. تنها با یک رویکرد فعالانه و تطبیقی میتوانیم از مزایای هوش مصنوعی در عین به حداقل رساندن خطرات امنیتی آن بهرهمند شویم.

0 نظر

هنوز نظری برای این مقاله ثبت نشده است.